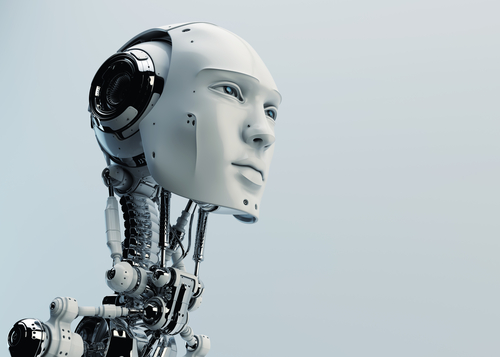

L’intelligenza artificiale è ormai dappertutto, grazie al dilagare delle macchine che sfruttano le capacità di apprendimento profondo. Ma prima che gli scienziati possano fidarsene tanto da usarle nelle loro ricerche, devono comprendere in che modo imparano, ed è un compito tutt’altro che semplice. Dean Pomerleau ricorda ancora il suo primo braccio di ferro con il problema della scatola nera. L’anno era il 1991 ed era impegnato in un pionieristico tentativo di raggiungere un risultato che oggi è comune nella ricerca sui veicoli a guida autonoma: insegnare a un computer come guidare.

Il progetto consisteva nel guidare un veicolo militare Humvee appositamente modificato attraverso strade urbane, ricorda Pomerleau, che allora era uno specializzando di robotica alla Carnegie Mellon University di Pittsburgh, in Pennsylvania. Con lui nell’Humvee c’era un computer che aveva programmato per guardare attraverso una telecamera, interpretare ciò che stava accadendo sulla strada e memorizzare ogni sua (di Pomerleau) azione di risposta. Alla fine, sperava Pomerleau, la macchina avrebbe avuto a disposizione un numero di associazioni sufficiente per guidare da sola.

In ogni viaggio, Pomerleau addestrava il sistema per qualche minuto, per poi lasciarlo andare a se stesso. Tutto sembrava andare bene, finché un giorno l’Humvee, avvicinandosi a un ponte, improvvisamente deviò da un lato. Pomerleau evitò l’incidente solo afferrando velocemente il volante e riprendendo il controllo. Tornato in laboratorio, Pomerleau cercò di capire dove aveva sbagliato il computer. “Una parte della mia tesi è consistita nell’aprire la scatola nera e capire che cosa stava ‘pensando’ “. Ma come? Aveva programmato il computer per agire come una rete neurale – un tipo di intelligenza artificiale (IA) ispirata al cervello che prometteva di funzionare meglio degli algoritmi standard nel gestire le situazioni complesse del mondo reale.

Purtroppo, queste reti sono anche opache quanto il cervello. Invece di memorizzare ciò che hanno appreso in un blocco ordinato di memoria digitale, distribuiscono le informazioni in un modo molto difficile da decifrare. Pomerleau riuscì ad afferrare il problema solo dopo un gran numero di test sulle risposte del software a vari stimoli visivi: la rete stava usando i margini erbosi della strada come indizio per la direzione da seguire, per cui l’aspetto del ponte l’aveva confusa.

Venticinque anni dopo, decifrare la scatola nera è diventato sempre più difficile e più urgente. La tecnologia è esplosa sia in complessità che in numero di applicazioni. Pomerleau, che ora insegna robotica alla Carnegie Mellon, descrive il suo piccolo sistema sull’Humvee come “una versione povera” delle enormi reti neurali che vengono usate per le macchine di oggi.

E le tecniche di apprendimento profondo, in cui le reti vengono addestrate su enormi archivi di dati, hanno applicazioni commerciali che vanno dalle automobili a guida autonoma ai siti Internet che consigliano prodotti in base alla storia di navigazione di un utente.

L’apprendimento profondo promette di diventare onnipresente anche in ambito scientifico. I futuri osservatori radioastronomici ne avranno bisogno per trovare segnali utili nella mole altrimenti ingestibile dei loro dati; i rivelatori di onde gravitazionali lo useranno per identificare ed eliminare le più piccole fonti di rumore; e gli editori lo useranno per setacciare e “taggare” milioni di articoli e libri scientifici.

Alla fine, secondo alcuni ricercatori, i computer dotati di apprendimento profondo potranno anche manifestare immaginazione e creatività. “Butteremo dei dati in pasto alla macchina, e quella restituirà leggi di natura”, dice Jean-Roch Vlimant, fisico al California Institute of Technology a Pasadena.

Ma questi progressi renderebbero il problema della scatola nera ancora più acuto. Come fa la macchina a trovare i segnali utili, per esempio? E come si può essere sicuri che non sbagli? Fino a che punto dovremmo essere disposti a fidarci dell’apprendimento profondo?

“Penso che stiamo sicuramente perdendo terreno rispetto a questi algoritmi”, dice Hod Lipson, esperto di robotica alla Columbia University a New York City. Egli paragona la situazione all’incontro con una specie aliena intelligente i cui occhi hanno recettori non solo per i colori primari – rosso, verde e blu – ma anche per un quarto colore. Sarebbe molto difficile per gli esseri umani capire come vede il mondo l’alieno, e per lui spiegarlo a noi. I computer avranno difficoltà analoghe nello spiegaci le cose a noi, dice Lipson. “In un certo senso, è come spiegare Shakespeare a un cane.”

Di fronte a queste sfide, gli esperti di intelligenza artificiale stanno rispondendo proprio come Pomerleau: aprendo la scatola nera e facendo l’equivalente di ciò che fanno le neuroscienze.

Le risposte non sono però una vera comprensione, dice Vincenzo Innocente, fisico del CERN, il laboratorio che ha aperto la strada all’applicazione dell’IA nella fisica delle particelle. “Come scienziato – dice – non mi basta saper distinguere i gatti dai cani. Uno scienziato vuole essere in grado di dire: ‘la differenza è in questo e in questo”.

Buon viaggio

Le prime reti neurali artificiali risalgono agli inizi degli anni cinquanta, quando furono a disposizione computer in grado di eseguire algoritmi. L’idea è simulare piccole unità di calcolo – i “neuroni” – disposte in strati collegati da una moltitudine di “sinapsi” “digitali. Ogni unità dello strato di fondo riceve dati esterni, come i pixel di un’immagine, e poi distribuisce questa informazione ad alcune o a tutte le unità nello strato successivo. Ogni unità nel secondo strato integra quindi gli ingressi dal primo strato, usando una semplice regola matematica, e passa il risultato più in alto. Alla fine, lo strato superiore produce una risposta, per esempio classificando l’immagine originale come quella di un ‘gatto’ o di un ‘cane’.

La potenza di queste reti deriva dalla loro capacità di apprendimento. Partendo da un insieme di dati di addestramento accompagnati dalle risposte giuste, possono migliorare progressivamente le loro prestazioni modificando la forza di ogni connessione fino a che le risposte del livello superiore sono corrette. Il processo, che simula il modo in cui il cervello impara rafforzando o indebolendo le sinapsi, alla fine produce una rete in grado di classificare correttamente dati nuovi che non facevano parte dell’insieme di addestramento.

Questa capacità di imparare rappresenta una grande attrattiva per i fisici del CERN fin dagli anni novanta, quando sono stati tra i primi a usare abitualmente reti neurali su larga scala in campo scientifico: le reti si sarebbero dimostrate di enorme aiuto nel ricostruire le traiettorie delle tracce subatomiche prodotte dalle collisioni di particelle al Large Hadron Collider del CERN.

Ma questa forma di apprendimento è anche il motivo per cui l’informazione è così diffusa nella rete: come nel cervello, la memoria è codificata nella forza di molteplici connessioni, invece di essere archiviata in posizioni specifiche, come in un database convenzionale. “Dove sta nel vostro cervello la prima cifra di un numero di telefono? Probabilmente in un gruppo di sinapsi, probabilmente non troppo lontano dalle altre cifre “, dice Pierre Baldi, studioso dell’apprendimento automatico all’Università della California a Irvine. Ma non c’è una sequenza definita di bit che codifica il numero. Di conseguenza, dice Jeff Clune, informatico all’Università del Wyoming a Laramie, “anche se costruiamo queste reti, non siamo più vicini a comprenderle di quanto lo siamo a comprendere un cervello umano”.

Per gli scienziati che hanno a che fare con grandi basi di dati, questo rende l’apprendimento profondo uno strumento da usare con cautela. Per capire perché, dice Andrea Vedaldi, informatico all’Università di Oxford, in Gran Bretagna, immaginiamo che in un prossimo futuro una rete neurale di apprendimento profondo sia addestrata usando vecchie mammografie classificate in base a quali donne hanno continuato a sviluppare il cancro del seno. Dopo questo addestramento, dice Vedaldi, il tessuto di una donna apparentemente sana potrebbe già rivelarsi canceroso alla macchina. “La rete neurale potrebbe avere implicitamente imparato a riconoscere i marcatori – caratteristiche che noi non conosciamo, ma che sono predittive del cancro,” dice.

Ma se la macchina non riesce a spiegare come fa a saperlo, spiega Vedaldi, porrebbe gravi dilemmi a medici e pazienti. E’ abbastanza difficile per una donna scegliere di sottoporsi una mastectomia preventiva perché ha una variante genetica nota per aumentare significativamente il rischio di cancro. Ma potrebbe essere ancora più difficile scegliere senza nemmeno sapere qual è il fattore di rischio, anche se la macchina a mostrato di essere molto precisa nelle sue previsioni.

“Il problema è che la conoscenza viene acquisita nella rete, e non in noi”, dice Michael Tyka, biofisico e programmatore di Google a Seattle, Washington. “Abbiamo davvero capito qualcosa? Non proprio, lo ha fatto la rete.”

Nel 2012 diversi gruppi hanno cominciato ad affrontare il problema della scatola nera. Uno di essi, diretto da Geoffrey Hinton, specialista dell’apprendimento automatico all’Università di Toronto, ha partecipato a una competizione di computer vision dimostrando per la prima volta che la capacità dell’apprendimento profondo di classificare le fotografie di un database di 1,2 milioni di immagini supera di gran lunga quella di qualsiasi altro approccio all’intelligenza artificiale.

Scavando più in profondità per capire come fosse possibile, il gruppo di Vedaldi ha preso gli algoritmi sviluppati da Hinton per migliorare l’addestramento della rete, e li ha fatti girare in senso inverso. Invece di insegnare a una rete a dare la corretta interpretazione di un’immagine, il gruppo è partito dalle reti pre-addestrate e ha cercato di ricostruire le immagini avevano prodotto. Questo ha aiutato i ricercatori a identificare in che modo la macchina stava rappresentando le diverse caratteristiche;: un po’ come se avessero chiesto a un’ipotetica rete neurale cerca-cancro ‘quale parte di questo mammografia hai deciso che è un marker di rischio tumorale?”

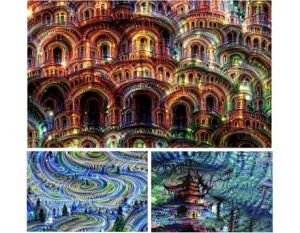

L’anno scorso, Tyka e i suoi colleghi di Google hanno seguito un approccio simile fino alle sue estreme conseguenze. Il loro algoritmo, che hanno chiamato Deep Dream, parte da un’immagine – per esempio un fiore o una spiaggia – e la modifica per migliorare la risposta di un particolare neurone di livello superiore. Se al neurone piace contrassegnare le foto come uccelli, per esempio, l’immagine modificata inizierà mostrando uccelli dappertutto. Le immagini risultanti evocano i viaggi con l’LSD, con gli uccelli che emergono da volti, edifici e molto altro ancora. “Penso che sia molto più simile a un’allucinazione” che a un sogno, dice Tyka, che è anche un artista. Quando lui e la sua squadra hanno visto il potenziale di un uso creativo dell’algoritmo, lo hanno reso disponibile permettendo a chiunque di usarlo. In pochi giorni, Deep Dream è diventato virale on-line.

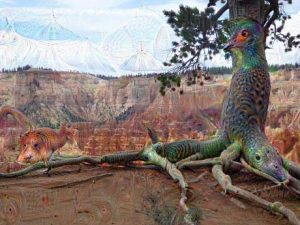

Usando tecniche che potrebbero massimizzare la risposta di qualsiasi neurone, non solo di quelli di primo livello, nel 2014 la squadra di Clune ha scoperto che il problema della scatola nera potrebbe essere più serio del previsto: è sorprendentemente facile ingannare le reti neurali con immagini di persone che sembrano un rumore casuale, o motivi geometrici astratti. Per esempio, una rete potrebbe vedere le linee sinuose e classificarle come una stella marina, o scambiare delle strisce bianche e gialle per uno scuolabus. Inoltre, gli schemi scelti hanno suscitato le stesse reazioni in reti che erano state addestrate su insiemi di dati differenti.

I ricercatori hanno proposto una serie di approcci per risolvere il problema dell’inganno, ma finora non è emersa alcuna soluzione generale. E questo nel mondo reale potrebbe essere pericoloso. Uno scenario particolarmente spaventoso, dice Clune, è quello in cui hacker malintenzionati potrebbero imparare a sfruttare queste debolezze. Potrebbero mandare una macchina a guida autonoma a sbattere su un cartellone che pensa sia una strada, o ingannare uno scanner della retina facendo entrare un intruso alla Casa Bianca, inducendo la rete a credere che sia Barack Obama. “Dobbiamo rimboccarci le maniche e fare scienza dura per rendere le macchine di apprendimento profondo più robuste e più intelligenti”, conclude Clune.

Problemi come questi hanno portato alcuni informatici a pensare che in fondo l’apprendimento con le reti neurali non dovrebbe essere l’unica carta da giocare. Zoubin Ghahramani, che studia apprendimento automatico a Cambridge, in Gran Bretagna, dice che se l’IA deve dare risposte che gli esseri umani possono facilmente interpretare, “c’è un mondo di problemi per i quali l’apprendimento profondo non è la risposta”.

Un approccio relativamente trasparente e in grado di fare scienza è stato presentato nel 2009 da Lipson e dal biologo computazionale Michael Schmidt, ora alla Cornell University di Ithaca, New York. Il loro algoritmo, chiamato Eureqa, ha dimostrato di poter riscoprire le leggi della fisica newtoniana solo guardando un oggetto meccanico relativamente semplice – un sistema di pendoli – in movimento.

Partendo da una combinazione casuale di “mattoni” matematici come +, -, seno e coseno, Eureqa segue un metodo per tentativi ed errori ispirato all’evoluzione darwiniana per modificare via via i termini fino ad arrivare alle formule che meglio descrivono i dati. Poi propone degli esperimenti per testare i suoi modelli. Uno dei suoi vantaggi è la semplicità, dice Lipson. “Un modello prodotto da Eureqa ha di solito una dozzina di parametri. Una rete neurale ne ha milioni. “

Il pilota automatico

L’anno scorso, Ghahramani ha pubblicato un algoritmo che consente di automatizzare il lavoro di uno scienziato, dall’osservazione dei dati grezzi fino alla scrittura di un articolo. Il suo software, chiamato Automatic Statistician, ha rilevato nell’insieme di dati tendenze e anomalie e ha presentato la sua conclusione, tra cui una spiegazione dettagliata della sua motivazione.

Una simile trasparenza, dice Ghahramani, è “assolutamente cruciale” per l’applicazione nella scienza, ma è importante anche per molte applicazioni commerciali. Per esempio, spiega, in molti paesi le banche che negano un prestito hanno l’obbligo legale di dire perché, cosa che un algoritmo di apprendimento profondo potrebbe non essere in grado di fare.

Preoccupazioni analoghe valgono per una vasta gamma di istituzioni, sottolinea Ellie Dobson, direttore di una sezione della Arundo Analytics di Oslo, una società di trattamento di grandi quantità di dati. Se qualcosa dovesse andare storto a causa dei tassi di interesse fissati in Gran Bretagna, dice Dobson , “la Bank of England non può dire, ‘la scatola nera mi ha fatto fare così'”.

Nonostante questi timori, gli informatici sostengono che gli sforzi per creare una IA trasparente dovrebbero essere visti come complementari all’apprendimento profondo, non come sostitutivi. Alcune delle tecniche trasparenti possono funzionare bene per problemi che sono già descritti come un insieme di fatti astratti, dicono, ma non sono molto bravi nella percezione, ossia nel processo di estrazione di fatti dai dati grezzi. In definitiva, sostengono questi ricercatori, le complesse risposte date dall’apprendimento automatico devono far parte degli strumenti della scienza, perché il mondo reale è complesso: per fenomeni come il clima o il mercato azionario, una sintetica descrizione riduzionista potrebbe anche non esistere.

“Ci sono cose che non possiamo verbalizzare”, afferma Stéphane Mallat, matematico all’Ecole Polytechnique di Parigi. “Quando si chiede a un medico perché ha diagnosticato questo o quello, cercherà di darvi alcuni motivi”, dice. “Ma come mai ci vogliono 20 anni per fare un buon medico? Perché l’informazione non è solo nei libri “.

Per Baldi, gli scienziati dovrebbero abbracciare l’apprendimento profondo senza essere “troppo pignoli” sulla scatola nera. Dopo tutto, tutti hanno una scatola nera nella loro testa. “Usiamo continuamente il cervello; ci fidiamo continuamente del nostro cervello; e non abbiamo idea di come funziona “.

(L’originale di questo articolo è stato pubblicato su Nature il 5 ottobre 2016. Traduzione ed editing a cura di Le Scienze. Riproduzione autorizzata, tutti i diritti riservati.)

Davide Castelvecchi/Nature